Cher tous,

Cette semaine, une fois encore, et je ne l’ai même pas fait exprès, il n’est fait aucune référence du mot qui commence par C et qui termine par S (ou par 19) dans cette newsletter.

Non, cette semaine encore on regarde en avant et on range ses attestations car on focus sur les choses qui nous font avancer fondamentalement : l’intelligence artificielle par exemple.

Alors encore un peu de courage, prenez soin de vous et bonne fin de weekend, amicalement,

Grégory

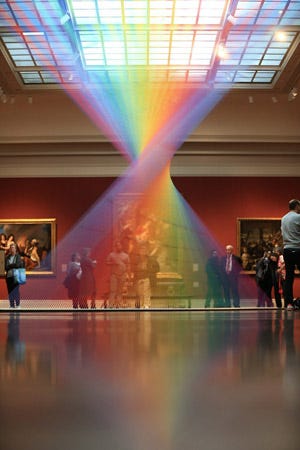

© Gabriel Dawe — Plexus no. 35 — Toledo Museum of Art

🧬 ‘It will change everything’: DeepMind’s AI makes gigantic leap in solving protein structures (Nature, Nov. 30, 2020)

Par Ewen Callaway

📝 3 choses à retenir de cette nouvelle révolution qui vole encore un peu sous les radars

DeepMind, le laboratoire britannique de Google spécialisée en I.A. (connu pour ses qualités de remarquable joueur de go), a annoncé en début de mois avoir mis au point un réseau d’intelligence artificielle, AlphaFold, capable de prédire la forme des protéines très complexes avec une précision et une efficacité jamais atteintes.

“This is a big deal,” says John Moult, a computational biologist at the University of Maryland in College Park, who co-founded CASP [biennial protein-structure prediction challenge] to improve computational methods for accurately predicting protein structures. “In some sense the problem is solved.”

C’est peut-être un détail pour vous mais pour les sciences de la vie ça veut dire beaucoup et ça risque tout simplement de changer la biologie telle que nous la connaissions. Vous allez me demander pourquoi —> car prédire convenablement la structure des protéines à partir de leur séquence d'acides aminés va considérablement accélérer les efforts pour comprendre comment sont construites les cellules et ainsi permettre de découvrir plus rapidement des médicaments plus efficaces. C.Q.F.D.

Le programme de Google sera ainsi complémentaire, en plus rapide, de l’étalon-or de la recherche, en l’espèce la technique expérimentale de la cristallographie aux rayons X ou encore la microscopie cryoélectronique. Mais ce sont encore les scientifiques qui en parlent le mieux :

“It’s a game changer,” says Andrei Lupas, an evolutionary biologist at the Max Planck Institute for Developmental Biology in Tübingen […]. AlphaFold has already helped him find the structure of a protein that has vexed his lab for a decade, and he expects it will alter how he works and the questions he tackles. “This will change medicine. It will change research. It will change bioengineering. It will change everything,” Lupas adds.”

Alors vous savez ce que l’on dit ? Merci Google bien-sûr !

🤖 Meet GPT-3. It Has Learned to Code (and Blog and Argue) (New York Times, Nov. 29, 2020)

Par Cade Metz

📝 fa-sci-nant

D’abord il y a un laboratoire d’intelligence artificielle à SF, OpenAI. Puis ce labo a dévoilé un nouveau système, GPT-3, qui a sagement passé des mois et des mois à apprendre sous toutes les coutures le langage naturel en analysant des milliers de livres, Wikipedia, et près d’un trillion de mots postés sur Internet (blogs, réseaux sociaux, and so on).

Pour les non-initiés, GPT-3 est un réseau neuronal, c’est-à-dire qu’il s’inspire grosso modo (tout est là) du fonctionnement du cerveau humain (vous savez, à force de voir de nombreuses photos d’une ville, au hasard New York, vous allez finir par reconnaître New York (parenthèse dans la parenthèse : Brooklyn Bridge)).

Digression —> On s’étonne parfois de la puissance de Gmail qui propose des phrases de plus en plus correctes. Cette magie, c’est celle de l’intelligence artificielle, qui s’abreuve de millions de textes pour prédire de plus en plus correctement ce que l’on souhaite écrire (et parfois cela va même dans le sens inverse : on se conforme à ce que l’intelligence artificielle veut que l’on dise, histoire de lui mettre du baume au cœur).

Résultat des course, GPT-3 peut répondre à des questions d’apparence complexes et écrire comme nous le ferions, nous, simples humains. Ainsi, à la question “Comment devenir plus créatif”, notre cher GPT-3 répond du tac au tac :

“I think creative expression is a natural byproduct of growing up in a diverse world. The more diverse the world is, the more you get exposed to different people, to different opportunities, to different places and to different challenges. And the more diverse that is, the more likely you’ll be to be able to put the dots together to form something new. And in many ways, I think if you want to be creative, you have to go for it. If you want to be a writer, you have to write, if you want to be a musician, you have to create music, if you want to be a comedian, you have to create comedy, and the more you create, the more likely it is that you’ll stumble onto some interesting stuff.”

Mais ce n’est pas tout. Les chercheurs se sont amusés à challenger le jeune GPT-3, et quelle ne fut pas la surprise de ces derniers :

“It generates tweets, pens poetry, summarizes emails, answers trivia questions, translates languages and even writes its own computer programs, all with very little prompting.”

Bien-sûr GPT-3 n’est pas parfait, et il rédige parfois des messages qui laissent à désirer. Mais le résultat global est impressionnant car il s’auto-alimente, et ce sans aucune aide extérieure. Et cette prouesse c’est l’aboutissement de longues années de travail, notamment chez OpenAI, avec un financement de 1 milliard de dollars, spécialement via Microsoft. Google a aussi son propre système.

Et cette famille de systèmes s’appellent des universal language models, qui peuvent par exemple être utilisés par des chatbots, pour résumer des articles (bientôt la fin de Dimanche Seven telle qu’on l’aura connue ?), ou plus généralement pour converser. Tous ces outils sont encore peu utilisés. Mais just a tip : ce n’est que le début les amis.

Alors vous savez ce que l’on dit ? Merci Microsoft bien-sûr ! (il y en aura pour tout le monde !).

🧮 Mathématiques : la France, dernière élève des pays développés (Le Monde, 8 décembre 2020)

Par Violaine Morin

📝 Alors voilà. Lapalissade (Wikipedia pour en savoir plus sur mon mot préféré) : le monde se digitalise à tout va (avec ce que cela implique en matière d’appétence et de maitrise des concepts mathématiques), on a les meilleurs élites et tout ça, mais nous sommes des cancres en maths. Too bad. Et une belle allégorie de Where Do We Stand en termes d’inégalités.

On ne présente plus le classement Timms, mais en même temps on va quand même le faire. Timms (Trends in International Mathematics and Science Study) c’est une enquête sur le niveau des élèves en maths et en sciences (CM1 et 4ème). Et le résultat n’est pas bon, confirmant une tendance de fond : la France est dernière de l’Union Européenne et avant-dernière de l’OCDE. Et, en soi, c’est une performance. Notre suprématie en maths, ce serait donc un effet d’optique ? Un biais lié à notre environnement ? Oh, que oui :(

Pour aller un plus dans le détail, le niveau des CM1 est égal à lui même versus la dernière enquête de 2015 (score de 485, soit bien en dessous des pays comparables). Mais, et comme souvent tout est dans cette conjonction, les 4ème n’avaient pas été évalués depuis 25 ans. Et là c’est un spectaculaire effondrement (on croirait lire le grand Marc Bloch dans L’Étrange défaite) : le score chute en moyenne de 47 points. Et l’auteure de ce papier de conclure par ce principe aux airs du Temps retrouvé de notre autre ami, Marcel Proust : “Pour le dire autrement, les élèves de 4e d’aujourd’hui sont les 5e d’hier.”

Pourquoi un tel effondrement ? Même s’il est difficile de décortiquer les facteurs de cette tragédie on en a déjà identifié un : le manque de formation mathématique des enseignants.

« Quand les futurs enseignants arrivent en master et commencent à se former, la plupart n’ont pas fait de mathématiques depuis plusieurs années », rappelle Edouard Geffray, le directeur général de l’enseignement scolaire (Dgesco), qui pointe une « forte corrélation » entre la baisse des compétences des élèves français et le sentiment de « manque de formation » sur ces domaines, qui revient d’étude en étude dans la bouche des enseignants.

Un plan de formation (des enseignants) a donc été mis en place. Mais les causes sont peut-être plus profondes, avec un serpent qui se mord la queue, et notamment des élèves qui arrivent au collège trop fragiles.

📱 The state of European tech 2020: 20 things you should know (Sifted, Dec. 8, 2020)

Par Freya Pratty et Amy Lewin

📝 Le monde de la tech européenne à son Père Noël. Et il s’appelle Atomico, du nom d’un des plus puissants fonds de venture capital du Vieux continent (son fondateur, Niklas Zennström, a interviewé cette semaine le Président Macron). Chaque année, Atomico publie son rapport très complet sur l’état de l’éco-système tech en Europe. En voici les 6 premières choses à retenir.

2020 va être une année record avec 41 milliards $ investis. Une tendance de fond : le développement des mega-rounds 100-250 m$ (par exemple les cuisines anglaises Karma Kitchens — 317 m$ —, les trottinettes allemandes Tier — 250 m$ — ou encore les marketplaces françaises de Mirakl — 300 m$).

Septembre a été un mois record avec 5 milliards $ investis dans les startups européennes.

La taille des tours de financement grossit. Ainsi les seeds (le premier tour significatif) est passé de 0,7 m$ en 2016 à 1,2 m$ en 2020 tandis que pour les Series A (quand la société a déjà une traction significative, avec en général un business model prouvé) on est passé de 3,9 m$ en 2016 à 6,6 m$. Pourquoi ce trend ? Des fonds plus gros et davantage d’interventions d’investisseurs US.

Il y a un problème sur les Series B. Sur ces tours de 20 à 50 m$, l’Europe est à la traine derrière les US. En cause, cette année notamment, des modes de consommations et de dépenses B2B disruptées : du coup le momentum pour lever de gros rounds en quête de croissance n’était pas là.

C’est une année-record pour la France. Et pour la première fois la barre de 5 milliards de dollars (en annualisé) de capital investi devrait être dépassé. La FR est ainsi le seul grand marché d’Europe a être en croissance. Bravo !

Londres demeure le hub européen et Stockholm est on the rise.

🎺 Bob Dylan sells entire publishing catalogue to Universal Music (The Guardian, Dec. 7, 2020)

Par Mark Sweney

📝 The Times They Are A-Changin' (elle est facile je sais)

C’est tout son légendaire catalogue de 600 chansons que Bob Dylan a vendu à Universal Music pour une valeur évoquée par le New York Times de plus de 300 m$.

C’est des des deals les plus lucratifs de l’histoire de la musique pour le Prix Nobel de littérature aux 125 millions de disques vendus.

A l’ère du streaming, la possession de catalogues redevient donc une market darling. Cela constitue ainsi une sorte de rente (un peu comme posséder un immeuble).

“Cashing in on catalogues is a booming business. The London-listed Hipgnosis Songs Fund, which gives investors the chance to make money from royalties generated by songs by artists from Beyoncé to Blondie, has spent £1.2bn buying 117 catalogues to date.”

🏘️ Airbnb soars on debut in latest IPO bounce (Financial Times, Dec. 10, 2020)

Par Richard Waters, Dave Lee et Miles Kruppa

📝 3 choses à retenir sur une des introductions en bourses les plus commentées de l’année

D’abord il faut retenir un succès. Mercredi les actions Airbnb étaient vendues 68$ aux investisseurs. Elles clôturaient la séance à 144,71 $ (!). Au closing de vendredi le titre était à 139,25 $ (x2 donc). Ce x2 est à mettre au regard du prix encore évoqué la semaine passée (44-50$, on serait donc à x3). Chapeau bas !

Cela nous amène à une capitalisation boursière de près de 83 milliards de dollars (environ 2 fois Marriott, la plus grande chaîne hôtelière du monde).

Les raisons de ce succès ? Les investisseurs bien-sur misent sur un rebond du tourisme (allié à la puissance du digital évidemment). Et il y aussi cette montagne de cash sur le marché, et le succès des IPOs et du parcours boursier des champions de la Tech, comme la visio Zoom Communications (“tu es sur mute il faut que tu te démutes” : 114 milliards de market cap) et les bases de données Snowflake (100 milliards, presque autant que le légendaire IBM).

Du coup cela amène la fortune du CEO Brian Chesky à 11 milliards de dollars.

Merci à tous ;) !